2025/03/10

技術進展が著しいAI について、いかに安全性を確保しつつ効果的に活用し産業競争力の強化につなげていくか、その針路についてわが国は今、重大な局面に立たされている。リスク対応と活用の機微な隘路の中で日本の社会・産業界はどのような方向性をたどるべきなのか、現在の主要論点とポイントを解説してもらった。

Tweet

生成AIの急激な進化と国内外の対応の変化

2023年4月に「チャットGPT」を開発している米国企業、OpenAI社のCEO(最高経営責任者)サム・アルトマン氏が来日して当時の岸田文雄首相と面会した頃から、生成AI活用の是非について議論が活発化し、さっそく5月には中央省庁でまず機密性の低い文書から、職員による生成AIの使用を認めていくことになりました。同じく5月に政府は「AI戦略会議」を設置して「AIに関する暫定的な論点整理」を取りまとめました。

この「論点整理」で示された日本のAI政策の三本柱は、①国際的な議論とリスクへの対応、②最適な利用、③開発力の強化であり、これに基づいて、リスクへの対応に関しては、まずは法律よりも機敏な対応が可能なガイドラインを中心に検討が始まりました。

一方、同じく5月に広島で開かれたG7サミット(主要7カ国首脳会議)では、日本が議長国として、信頼できる高度AIシステムに関するルールを策定する「広島AIプロセス」がスタートしました。

同じ頃、ヨーロッパではいち早くAI法規制の議論が進んでいましたが、米国においても近いうちにAI規制法が導入されるのではないかという説がありました。著名な科学者などがAIの高度化のリスクを指摘して話題になり、当時のバイデン大統領もAI規制の必要性について言及するなど、法規制へ向かう雰囲気もあったように思います。

結果的には、米国では7月末に主要IT企業(いわゆるビッグテック)が「ボランタリー・コミットメント(自主的取り組み)」を発表しました。これは、企業がホワイトハウスに対して、安全なAI開発のために自主的に努力しますと約束したような形です。安全性やセキュリティは確保しつつも、AI開発を停滞させず、イノベーションを促進させるという米国の意図かと思います。

米国では、同年10月末に大統領令が発表され、企業の自主的取り組みを尊重しつつも、安全保障上必要な場合には既存の法令を使うなど、できることを最大限進める姿勢を表明しました。武器開発にも利用可能と見られる大規模汎用AIモデルの開発者には、政府への事前の届出を求め、クラウドインフラを大量に使用する外国事業者を確認するといった方針が示されました。

11月には、英国のリシ・スナク首相が提唱したAIの安全性をテーマとする「AIセーフティサミット」が開催され、それをきっかけにAIの安全性向上策を検討するAIセーフティ・インスティテュート(AISI)が英国、米国、日本、シンガポール、韓国などで創設されることになりました。今後も設立する国が増えていくと思われます。

広島AIプロセス

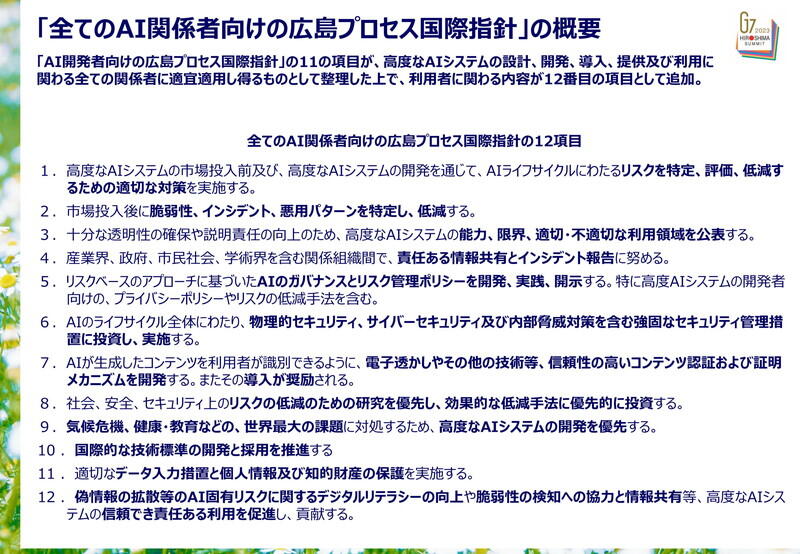

前述した「広島AIプロセス」は、閣僚級会議等を経て2023年末に国際指針を含む包括的な政策枠組みの合意に至りました。これは非常に大きな成果でした。23年に世界中で生成AIの急速な進化に対する懸念が広がっていた、まさにそのタイミングで世界初の国際的な指針等にG7各国が合意できたからです。全12項目で構成された内容は、大規模生成AIなどの高度なAIシステムに焦点を当て、全てのAI関係者向けの指針と、開発者向けの国際規範があります。

まず、AIを市場に投入する前にリスクを特定、評価、低減するための対策を求め、市場投入後には脆弱性やインシデントの発見と改善を求めています。また、AIの特性や限界、不適切な利用領域を公表すべきとしています。

それから、AIガバナンス方針の策定・開示など予防的な管理体制の構築を求めています。今では、たとえAIを利用している自覚がなくても実はバックグラウンドでAIが稼働しているといったケースも増えており、AI利用者は既に1億人以上に達しているかもしれません。こうした状況下で万一AIが不正に乗っ取られたらリスクは非常に深刻かつ広範に及ぶと考えられ、ソフトウェア、ハードウェア両面からの徹底したセキュリティ対策が欠かせません。

広島AIプロセスでは、AIで生成されたコンテンツを閲覧者が識別できるようにするための「電子透かし」やコンテンツの出典を閲覧者が知ることができる来歴管理技術の開発や導入が奨励されています。現在の技術では、画像をカメラで撮影してPDF化すると「電子透かし」が消えてしまうとか、まだテキストには対応できないといったこともあり、「奨励」という形にとどまりました。

指針ではAI利用者のリテラシー向上も重要なポイントとしています。AIは間違った回答をする可能性があるので、問題が発生した際に適切に対応できるように利用者がAIの仕組みを理解しておくことが重要です。

この指針には世界各国から賛同が集まりました。賛同国・地域が集まる「広島AIプロセス・フレンズグループ」の参加国・地域は現在55となっています。

AIガバナンスをめぐる議論の活発化

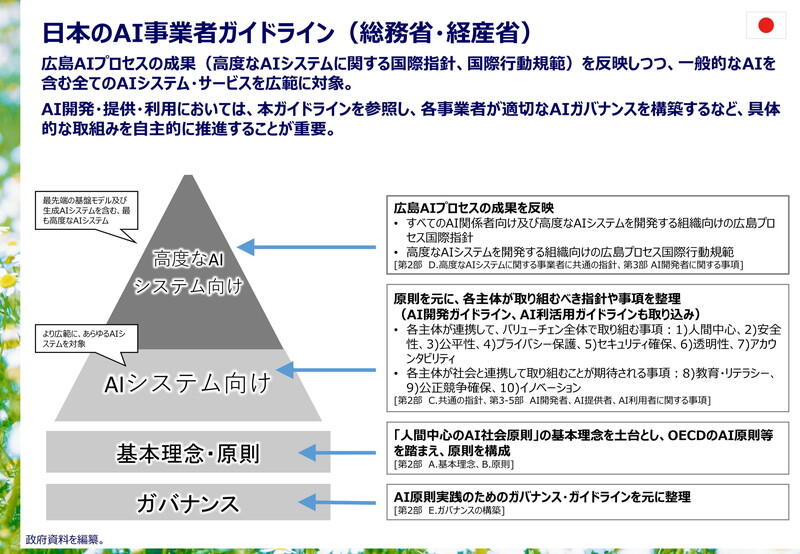

日本は、OECDのAI原則や広島AIプロセスの議論も踏まえ、総務省・経済産業省が2024年4月に「AI事業者ガイドライン(第1・0版)」を策定しました。高度なAIシステムを開発する事業者に対しては、広島AIプロセスの国際指針等が引用されています。AIの開発・利用の方法は事業者によって異なることから、すべてのAI関連事業者がそれぞれ自社のAI活用リスク等を考え、把握し、管理するためのポリシーを作成し、PDCAサイクル(計画・実行・評価・改善)を回すことが重要です。

AIの信頼性や安全性に関する国際的な議論は活発化し、2024年3月、国連総会において「持続可能な開発のための安全、安心で信頼できるAIシステムに係る機会確保に関する決議」が採択されました。わが国も当初から共同提案国として支持してきた決議です。

国連総会決議には広島AIプロセスでの議論の内容が多く取り入れられたほか、コンピューター・インフラが未整備の途上国や少数言語圏もAIにアクセスできるようにすべきという趣旨が込められています。

社会的に重要な意思決定へのAIの関与が増えていく可能性がある一方で、現状ではAIが学習するデータのほとんどが英語などの国際的にメジャーな言語なので、AIによる回答が偏る可能性を認識しておく必要があります。

24年5月には、AIに関する初めての国際条約が欧州評議会によって締結されました。主に政府や自治体による非軍事用途のAI使用を対象に人権保護などを義務付ける内容で、9月から各国による署名が始まり、ヨーロッパ以外でも署名する国があります。なお、軍事利用に関しては本条約の対象外で、国連ではLAWS(自律型致死兵器システム)規制について議論されています。

24年5月にはEUのAI法が成立しました。この法律は人権尊重やEUの価値観を前面に出している印象があります。AIをリスクの高さに応じて四つのレベルに分類し、例えば、カメラで顔を撮影して人物評価を行うようなAIシステムは禁止、医療機器にAIを使用する際には基準適合義務など、リスクが高いほど厳しい規制が課せられます。リスクが低い用途のAIについては自主的な取り組みを促進するというスタンスです。また、汎用AIモデルについては、技術文書の作成などを義務付け、大規模なモデルにはリスク評価や厳しいテストの実施などの義務を上乗せしています。

国連は、24年9月、AIに関する高級諮問機関の報告「人類のためのAI統治」を公表しました。地域ごとのAI格差を埋める基金の創設、多様な専門家で構成される独立した国際科学パネルの設置等の提言が盛り込まれています。